Page 163 - 《应用声学》2022年第5期

P. 163

第 41 卷 第 5 期 吴情等: 基于深度学习的语声抑郁识别 839

说,如果最想看的那个东西总是出现在某一部分时, 小为 n × 2u。然后通过注意力机制,将 LSTM 的整

以后再在相似的场景中,就会把注意力放到这部分 个隐藏状态 H 作为输入,首先将输入经过 Dense

上,尽量不去看其他部分,节省时间以提高效率。 层,且使用 softmax 变换将 Dense 层输出结果转化

注意力机制最关键的部分就是计算一串权重 为[0,1] 之间的数,确保所有计算出的权重之和为1,

参数,它从序列中学习每一个元素的重要程度,然后 从而得到注意力权重a:

按重要程度将元素合并 [15] 。这串权重参数也称为 T

a = soft max(w s2 tanh(w s1 H )), (2)

注意力分配系数,它决定了给哪个元素分配多少注

其中,w s1 、w s2 都是可以学习的模型参数, w s1 大小

意力,权重参数越大,则代表这个元素对于结果更

有效。 为2u × d ,w s2 大小为d,则a的大小为n。

然后将a和LSTM隐藏状态H 进行求和,得到

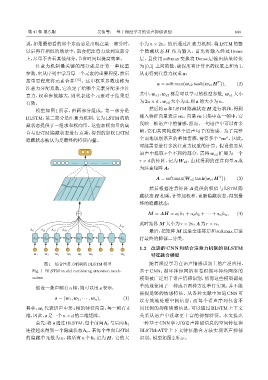

模型如图 1 所示,由两部分组成。第一部分是

BLSTM,第二部分是注意力机制,它为 LSTM 的隐 输入特征向量表示 m。向量m 只集中在一帧中,它

藏状态提供了一组求和权向量。这些加权向量的集 反映一帧语声中的情感,然而,一句语声中可以有多

合与 LSTM 隐藏状态进行点乘,得到的加权 LSTM 帧,它们共同构成整个语声句子的情感。为了完整

隐藏状态被认为是最终的特征向量。 全面地识别语声的整体情感,需要多个 “m”。因此,

可能需要进行多次注意力权重的计算。假设想要从

语声中提取 r 个不同的部分,需将 w s2 扩展为一个

r × d 的矩阵,记为 W s2 ,由此得到的注意向量 a 成

ĀĀ ĀĀ ĀĀ

为注意矩阵A:

T

A = soft max(W s2 tanh(w s1 H )). (3)

m

m m m Ā m r

然后根据注意矩阵 A 提供的权值与 LSTM 隐

藏状态 H 相乘,计算加权和,更新隐藏状态,得到最

终的隐藏状态:

M = AH = a 1 h 1 + a 2 h 2 + · · · + a n h n , (4)

此时矩阵M 大小为r × 2u,A为r × n。

A in

A i A i A i A i Ā 最后,把矩阵 M 送进全连接层和softmax 层进

h h h h h h Ā Ā h n 行最终的抑郁二分类。

1.2 改进的 CNN 和结合注意力机制的 BLSTM

Ā Ā

w w w w w w w n 特征融合模型

图 1 结合注意力机制的 BLSTM 模型 随着深度学习在语声情感识别上的广泛应用,

Fig. 1 BLSTM model combining attention mech- 基于 CNN、循环神经网络和卷积循环神经网络的

anism 模型被广泛用于语声情感识别,然而这些模型都是

假设一条声频有n帧,则可以用s表示: 单纯地使用了一种或者两种方法串行实现,并不能

捕捉足够的情感特征。从各种文献中知道 CNN 可

s = (w 1 , w 2 , · · · , w n ), (1)

以有效地处理空间信息,而每个语声序列包含不

其中,w i 代表语声中第 i 帧的特征向量,每一帧有 d 同比例的抑郁情感信息,可以通过 BLSTM 上下文

维,因此,s是一个n × d的二维矩阵。 关系从语声中获取更丰富的抑郁特征。本文提出

一种基于 CNN 学习的语声抑郁信息的空间特征和

首先,将s通过BLSTM,每个前向h t 与后向h t

连接起来得到一个隐藏状态h t 。若每个单向LSTM BLSTM-ATT 上下文特征融合方法实现语声抑郁

的隐藏单元数为 u,将所有 n 个 h t 记为 H,它的大 识别。模型如图2所示。