Page 217 - 《应用声学》2023年第3期

P. 217

第 42 卷 第 3 期 王玫等: 基于轻量级卷积门控循环神经网络的语声增强方法 655

W t֓

h t֓

σ

֓

h t

W x֓

W t֓

x t֓

σ

σ

f t

~

W x h t

W t

tanh

x t

σ

x t x t

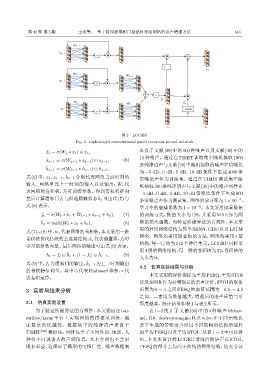

图 2 LCGRU

Fig. 2 Lightweight convolutional gated recurrent neural network

ˆ x t = σ(W x ∗ x t ) ⊙ x t , 来自于文献 [29] 中的 100 种噪声以及文献 [30] 中的

15 种噪声。通过在 TIMIT 训练集中随机提取 1000

ˆ x t−1 = σ(W x−1 ∗ x t−1 ) ⊙ x t−1 , (6)

条纯净语声与文献[29] 中随机抽取的噪声在信噪比

ˆ

h t−1 = σ(W h−1 ∗ h t−1 ) ⊙ h t−1 ,

为 −5 dB、0 dB、5 dB、10 dB 条件下生成 4000 条

式 (6) 中,x t 、x t−1 、h t−1 分别代表网络当前时刻的 带噪语声作为训练集。通过在 TIMIT 测试集中随

输入、网络单元上一时刻的输入以及输出;W ∗ 代

机抽取 200 条纯净语声与文献 [30] 中的噪声同样在

表网络的卷积核,为可训练参数。得到带权特征向

−5 dB、0 dB、5 dB、10 dB 信噪比条件下生成 800

˜

量后计算遗忘门f t 与候选隐藏状态h t 可由式(7)与 −4

条带噪语声作为测试集。网络的学习率为1 × 10 ,

式 (8)表示: −6

学习率的衰减系数为 1 × 10 。本文采用批量数据

f t = σ(W t ∗ ˆx t + W t−1 ∗ ˆx t−1 + b f ), (7) 的训练方式,批量大小为 128,并采用 MAE 作为网

˜ (8) 络的损失函数。为验证所提算法的有效性,本文采

h t = tanh(W h ∗ x t + b h ),

用的对比网络结构为简单 SRNN、GRU以及 LSTM

式(7)∼(8)中,w ∗ 代表网络的卷积核,本文采用一维

网络。网络均采用层叠加的方法,网络均采用 4 层

卷积核替代传统的全连接结构;b ∗ 代表偏置项,为可

结构,每一层均为 512个神经单元。LCGRU同样采

学习的参数向量。最后网络的输出可由式(9)表示:

用4层的网络结构,每一层的卷积核为32,卷积核的

ˆ

˜

h t = f t ⊙ h t + (1 − f t ) ⊙ h t−1 , (9)

大小为9。

ˆ

式(9) 中,f t 为遗忘门的输出,h t−1 为上一时刻输出

3.2 仿真实验结果与分析

的带权特征向量。其中 ⊙ 代表 Hadmard 乘积,∗ 代

本文采用的评价指标为平均PESQ、平均STOI

表卷积运算。

以及SSNR作为对增强后的语声评价。STOI的取值

3 实验与结果分析 范围为 0 ∼ 1 之间 PESQ 的取值范围为 −0.5 ∼ 4.5

之间。二者均为数值越大,增强后的语声质量与可

3.1 仿真实验设置 懂度越高。统计结果如表1与表2所示。

为了验证所提算法的有效性,本文通过在 ten- 表 1∼2 统计了文献 [30] 中的 4 种噪声 hfchan-

sorflow/keras 平台上实现网络的搭建及训练,验 nel、f16、destroyerengine 以及 volvo 在不同信噪比

证算法的优越性。数据集中的纯净语声来自于 条下生成的带噪语声经过不同的网络结构增强后

TIMIT [28] 数据集,同时包含了不同性别、地区、人 的平均PESQ以及平均STOI。从表1 ∼ 2中可以得

种等不同说话人的声频信息,文本方面也不会出 出,本文所设计的 LCGRU 增强后的语声在 STOI、

现有重叠,这保证了模型的可推广性。噪声数据集 PESQ 的得分上均高于传统的网络结构,这充分证