Page 83 - 《应用声学》2023年第1期

P. 83

第 42 卷 第 1 期 胡航烨等: 汉语儿童情感语声合成 79

Ѭឈܫေ 的特征迁移。

ᮄ॥ಖฌ 类似于多说话人的情感语声合成,理想状态下,

వηৌ ᮄ॥ηৌ 利用低维级的说话人嵌入向量可以实现低资源的

ʷ ߚᣁૃᮃ 语声合成,而在文献 [31] 中利用 Tacotron 模型进行

ʷ

ࠫ 多说话人语声合成时发现 Tacotron 模型的性能高

ᴏ

Ѭࣝҫቔ 度依赖模型的超参数,利用小数据集进行训练时无

ܦᮠηՂ Ϭ᧗Ձԫ૱ 法进行注意力机制的学习。因此本文在不考虑多说

̄፥ηՂڏ 话人语声合成的条件下,将ESD情感语料库中单人

ᆁϬ᧗Ձԫ૱ 女性的 4种情感语声中的说话人的相关参数存储在

ଢԩྲढ़ 低维向量中,在行儿童特征迁移时,儿童的嵌入向量

可以共享几乎全部的权重,解决了 Tacotron模型的

图 2 文本声频预处理

性能高度依赖模型的超参数的问题。成人情感语料

Fig. 2 Text and audio preprocessing

选择成年女性作为说话者,其目的是接近儿童的韵

2.2 特征迁移 律特征 [3] 。

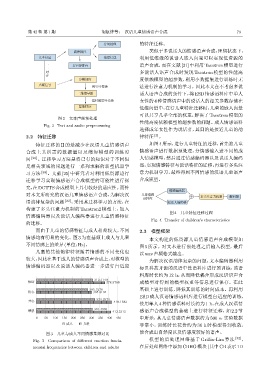

特征迁移的目的是减少在汉语儿童情感语声 如图4所示,进行儿童特征的迁移,首先将儿童

合成上其所需的数据量以及缩短模型的训练时 情感语声进行数据预处理,分情感输入进不同的成

间 [29] 。迁移学习方法是将已有的知识对于不同但 人情感模型,然后通过情感编码器以及说话人编码

是相关领域的问题进行一系列求解的新型机器学 器,实现情感特征与说话特征的迁移,再进行多头注

习方法 [30] 。文献 [25] 中研究者对利用低资源进行 意力机制学习,最终得到不同情感的汉语儿童语声

迁移学习实现情感语声合成模型的可能性进行探 合成模型。

究,在DCTTS合成模型上具有较好的适应性。而针

ৱਖᎄᆊ٨

对本文所研究的汉语儿童情感语声合成,为解决汉 Јቨৱਖ

ឦநः ܳ݀ฌਓҧ҄ ᝍᆊ٨

语韵律复杂的问题 [22] ,采用其迁移学习的方法,在 ឭភ̡ᎄᆊ٨

构建了多头注意力机制的 Tacotron2 模型上,加入

图 4 儿童特征迁移过程

情感编码器以及说话人编码器进行儿童情感特征

Fig. 4 Transfer of children’s characteristics

的迁移。

而由于儿童的情感特征与成人相差较大,不同 2.3 模型框架

情感均有明显的变化。图 3 为在基频上成人与儿童 本文构建的低资源儿童情感语声合成模型如

不同情感上的差异(单位:Hz)。

图 5 所示。对文本进行预处理之后输入模型,最后

儿童的其他韵律特征随着情感的不同变化也

以wav声频格式输出。

较大,因此在基于成人的情感语声合成上,对模型的 为解决汉语韵律复杂的问题,文本编码器利用

情感编码器以及说话人编码器进一步进行自适应 标贝科技开源的汉语中性语料库进行预训练,该语

料库时长约为 12 h,从而降低耦合形成汉语语声合

312.3149

৳ᝳ 378.9768 成模型对得到的模型权重等信息进行保存。在此

285.3278 基础上进行训练,降低其训练的时间成本。再利用

͞ॷ 305.6194

ESD 成人汉语情感语料库进行模型自适应的训练,

324.2574

नॷ 418.1583

使用单人 4 种情感语料时长约为1 h,在成人汉语情

310.4969

ਙড 413.3312 感语声合成模型的基础上进行特征迁移,如 2.2 节

0 50 100 150 200 250 300 350 400 450 中所示,其儿童情感语声数据约为 500 s,实验数据

ੇ̡ Јቨ 非常小,训练时长花费约为 36 h 时模型得到收敛,

图 3 儿童与成人不同情感基频对比 能合成出自然度以及情感度较好的语声。

Fig. 3 Comparison of different emotion funda- 模型的后处理网络基于 Griffin-Lim 算法 [32] ,

mental frequencies between children and adults 在后处理网络中添加 CBHG模块(其中CB表示1D