Page 82 - 《应用声学》2023年第2期

P. 82

270 2023 年 3 月

度的参数,仅保留信息量最大、最重要的参数。同

0 引言

时对剩余的参数进行一定的微调以保证一致性 [5] 。

另一类有效的模型压缩方法是网络量化 (Network

语声增强的研究旨在消除背景噪声,提高语声

quantization),其通过减少表示每个权重所需的位

的质量和可懂度。自20世纪50年代以来,语声增强

数来压缩原始网络 [6] 。而本文主要关注知识蒸馏

算法已经吸引了国内外众多学者的关注 [1−2] 。语声

的方法,其核心思想是将知识从大型教师模型传

增强方法在改善人类或机器对语声的理解方面有

递给小型学生模型 [7] 。师生学习多应用于分类任

重要的作用,包括助听器、语声通信和自动语声识别

务,在语声增强这样的回归任务上的相关工作并

等任务。本文主要关注单通道的语声增强方法。传

不多见。本文提出了一种用于语声增强模型的师

统的语声增强方法通常基于统计信号处理理论,对

生学习方法,通过拉近师生模型输出的距离,将

带噪语声应用频带抑制增益或滤波器。但这类方法

大规模教师模型的有效信息传递给学生模型。同

往往基于很多经验性的假设,并且难以应对非平稳

时,使用多分辨率频谱(Multi-resolution short-time

的噪声 [3] 。

Fourier transform, MRSTFT) 损失 [8] 代替原深度

得益于深度学习的发展,语声增强任务被定义

复卷积递归网络(Deep complex convolution recur-

为一个有监督的学习问题。这种数据驱动的方法

rent network, DCCRN) 模型使用的尺度不变信噪

渐渐成为主流,因为它能够从海量的带噪和干净语

比(Scale-invariant source-to-noise ratio, SISNR)损

声对挖掘有效信息,从而学到强大的噪声抑制能力

失,进一步提升低复杂度学生模型的效果。

(特别是对于非平稳噪声)。众多基于深度学习的模

型已经在单通道的语声增强任务报告了优良的性

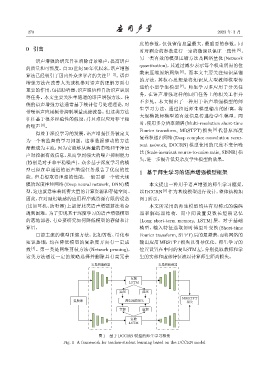

1 基于师生学习的语声增强模型框架

能。但若想取得理想的性能,一般需要一个较大规

模的深度神经网络(Deep neural network, DNN)模 本文提出一种用于语声增强的师生学习框架,

型,这也就意味着耗费大量的计算资源和存储空间。 以 DCCRN [9] 作为基线模型进行设计,整体结构如

因此,在对延迟敏感的应用程序或资源有限的设备 图1所示。

(比如耳机、助听器) 上部署此类语声增强算法将会 本文所采用的师生模型均具有对称式的编码

遇到困难。为了实现基于深度学习的语声增强模型 器和解码器结构,而中间设置复数长短期记忆

的落地部署,有必要研究如何降低模型的存储和计 (Long short-term memory, LSTM) 层。对于基础

算量。 模型,输入特征选取短时傅里叶变换 (Short-time

目前主流的模型压缩方法,比如剪枝、量化和 Fourier transform, STFT)后的复频谱,而将网络的

知识蒸馏,均在降低模型的复杂度方面有一定成 输出应用 MRSTFT 损失以引导优化。师生学习的

效 [4] 。第一类是网络剪枝方法 (Network pruning), 位置设置在中间的复 LSTM 层,分别提取教师和学

这类方法通过一定的策略选择并删除具有高冗余 生的实部和虚部特征流以计算师生距离损失。

ܭԄሥᎄᆊ٨ ܭԄሥᝍᆊ٨

ܭ

LSTM

ࠄᦊ ᘿᦊ

MRSTFT

ܭᮠ៨ ࣎ၷᡰሏ૯ܿ ૯ܿ

ࠄᦊ ᘿᦊ

ܭ

LSTM

图 1 基于 DCCRN 模型的师生学习框架

Fig. 1 A framework for teacher-student learning based on the DCCRN model