Page 20 - 《应用声学》2024年第6期

P. 20

1196 2024 年 11 月

ᝫጷᬷ↼x i) 次声信号的上下文特征。同时不同类别、不同强度

的次声源的次声信号持续时间并不相同,如地震产

ᮕܫေ

生的次声信号常会持续 20 s 以上,而闪电产生的相

LSTM ࢦКՔ᧚ቇᫎ ↼f↼x i↽↽ 关次声信号通常只会持续几秒钟的时间。为解决可

ᎄᆊӭЋ 变时长次声信号的编码问题,充分利用长时次声信

号携带的信息,本方法采用 LSTM 模型作为基于原

ܦ͈̃

ዝԔی ए᧚ᡰሏ Ѭዝគ 型网络的次声事件分类模型的编码单元,对输入次

ត តನవ ᝠካӭЋ ѿፇ౧ 声信号进行特征编码。LSTM 网络是一种时间循环

ನవ ࢦК᛫ᇨ

神经网络,但与一般的循环神经网络不同,LSTM网

ѿӭЋ

络解决了一般的循环神经网络存在的长期依赖问

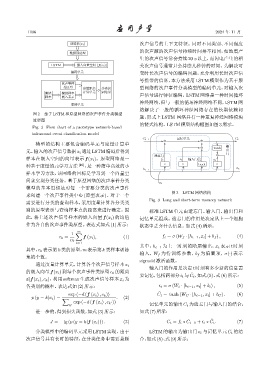

图 2 基于 LSTM 和原型网络的次声事件分类模型

题,形式上LSTM 网络具有一种重复神经网络模块

流程图

的链式结构。LSTM模型结构框图如图3所示。

Fig. 2 Flow chart of a prototype network-based

infrasound event classification model

ʍ ʍ

C t֓ ᝮॺӭЋ C t

模型的结构主要包含编码单元与度量计算单

ʍ tanh ᣥ

元。输入的次声信号数据x i 通过LSTM编码后得到 ѣ

᥌᫃ ʍ ᫃

样本在嵌入空间的向量表示 f(x i )。原型网络是一 f t i t ᣥК᫃C t o t

~

种基于度量的元学习方法 [16] ,是一种简单高效的小 σ σ tanh σ

h t

h t֓

样本学习方法,该网络的目标是学习到一个向量空

间来实现分类任务。基于原型网络的次声事件分类

x t

模型的基本思想是对每一个需要分类的次声事件

图 3 LSTM 网络结构

来创建一个次声事件类中心 (原型表示)。对于一个

Fig. 3 Long and short-term memory network

需要进行分类的查询样本,采用度量计算各分类类

别的原型表示与查询样本点的距离来进行确定。因 标准 LSTM 单元由遗忘门、输入门、输出门和

此,将上述次声信号样本的嵌入向量 f(x i ) 的均值 记忆单元组成。遗忘门的作用是决定从上一个细胞

作为各自的次声事件类原型。表达式如式(1)所示: 状态中丢弃什么信息。如式(4)所示:

m

1 ∑

c k = f (x i ), (1) f t = σ (W f · [h t−1 , x t ] + b f ) , (4)

m

i=1

其中,h t−1 为上一时刻的隐层输出,x t 表示 t 时刻

其中,c k 表示第 k 类的原型,m表示第 k 类样本训练

输入,W f 为待训练参数,b f 为偏置项,σ(·) 表示

集的个数。

sigmoid激活函数。

通过度量计算单元,计算各个次声信号样本 x i

输入门的作用是决定 t 时刻有多少新的信息需

的嵌入向量f(x i ) 到每个次声事件类原型 c k 的距离

˜

要记忆,包括两部分i t 与C t ,如式(5)、式(6)所示:

d(f(x i ), c k ),利用 softmax 生成次声信号样本 x i 为

各类别的概率。表达式如(2)所示: i t = σ (W i · [h t−1 , x t ] + b i ) , (5)

˜

exp (−d (f (x i ) , c k )) C t = tanh (W C · [h t−1 , x t ] + b C ) . (6)

. (2)

p (y = k|x i ) = ∑

exp (−d (f (x i ) , c k ))

′

k ′ 记忆单元的输出 C t 为遗忘门与输入门的结合,

进一步的,得到损失函数,如式(3)所示: 如式(7)所示:

˜

J = − lg (p (y = k|f (x i ))) . (3) C t = f t ∗ C t−1 + i t ∗ C t . (7)

分类模型中的编码单元采用LSTM实现。由于 LSTM 的输出为输出门 o t 与记忆单元 C t 的结

次声信号具有长时的特征,在分类任务中需要兼顾 合,如式(8)、式(9)所示: