Page 58 - 《应用声学》2025年第3期

P. 58

592 2025 年 5 月

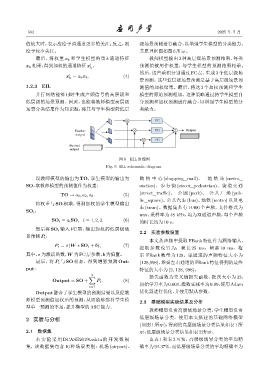

值较大时,表示应给予该通道更多的关注;反之,则 级场景预测进行融合,以增强学生模型的分类能力。

给予较少关注。 其原理框图如图6所示。

最后,将权重 α k 和学生模型的第 k 通道特征 教师模型输出 3 种高层级场景预测结果,每类

x k 相乘,得到加权的通道特征x , 预测值被用作权重,与学生模型的预测结果相乘。

′

k

然后,这些乘积分别通过 FC 层,生成 3 个低层级场

′

x = a k x k . (4)

k

景预测。这些低层级场景预测是基于高层级场景预

1.2.3 EIL 测值的加权结果。最后,将这 3 个加权预测和学生

并行网络能够同时生成声频信号的高层级和 模型的原始预测相加。这种策略通过将学生模型自

低层级的场景预测。因此,也能将教师模型高层级 身预测和加权预测进行融合,以增强学生模型的分

场景分类结果作为知识源,将其与学生模型的低层 类能力。

FC

Teacher FC ∑ Output

output

FC

Student

output

图 6 EIL 原理图

Fig. 6 EIL schematic diagram

设教师模型的输出为 TO,学生模型的输出为 购 物 中 心 (shopping_mall)、 地 铁 站 (metro_

SO,取教师模型的预测值作为权重: station)、步行街 (street_pedestrian)、街道交通

TO → a 1 , a 2 , a 3 . (5) (street_traffic)、 公 园 (park)、 公 共 广 场 (pub-

lic_square)、公共汽车 (bus)、地铁 (metro) 以及电

将权重与 SO 相乘,得到加权的学生模型输出

车 (tram)。数据集共有 14400 个声频,文件格式为

SO i :

wav,采样率为 48 kHz,均为双通道声频,每个声频

SO i = a i SO, i = 1, 2, 3. (6) 的时长均为10 s。

然后将 SO i 输入 FC 层,输出加权的低层级场

2.2 实验参数设置

景预测P i :

本文从声频中提取 FBank 特征作为网络输入,

P i = σ(W ∗ SO i + b), (7)

提取参数设置为:帧长 25 ms,帧移 10 ms,梅

其中,σ 为激活函数,W 为FC层参数,b为偏置。 尔 FBank 数量为 128。单通道的声频特征大小为

最后,将 P i 与 SO 相加,得到增强预测 Out- (128,998),堆叠左右通道的FBank 特征得到的最终

put: 特征的大小为(2, 128, 998)。

3

∑ 损失函数为交叉熵损失函数,批次大小为 32,

Output = SO + P i . (8)

初始学习率为0.001,指数衰减率为0.99,使用Adam

i=1

Output融合了学生模型的预测结果以及经教 优化器进行优化,并使用默认参数。

师模型预测值加权后的预测,从而能够弥补学生模 2.3 基础模型实验结果及分析

型单一预测的不足,提升模型的ASC能力。

教师模型负责高层级场景分类,学生模型负责

2 实验与分析 低层级场景分类。使用本文搭建的基础网络模型

(如图1 所示),得到的高层级场景分类结果如表1 所

2.1 数据集 示,低层级场景分类结果如表2所示。

本 实 验 采 用 DCASE2019task1a 的 开 发 数 据 由表 1 和表 2 可知,高层级场景分类的平均精

集,该数据集包含 10 种场景类别:机场 (airport)、 确率为 94.37%,而低层级场景分类的平均精确率为