Page 115 - 201806

P. 115

第 37 卷 第 6 期 杨洋等: 基于改进卷积神经网络算法的语音识别 945

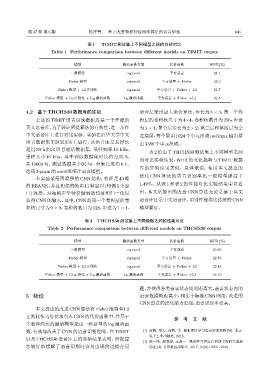

表 1 TIMIT 测试集上不同模型之间的性能对比

Table 1 Performance comparison between different models on TIMIT corpus

模型 激活函数类型 代价函数 WER(%)

一般模型 sigmoid 平方误差 24.1

Fisher 模型 sigmoid 平方误差 + Fisher 23.0

Fisher 模型 + L2 正则化 sigmoid 平方误差 + Fisher + L2 22.7

Fisher 模型 + L2 正则化 + log 激活函数 log 激活函数 平方误差 + Fisher +L2 22.5

4.2 基于THCHS30数据库的实验 聚合层采用最大聚合算法,步长为 3 × 3;第二个卷

上述的 TIMIT 语音识别数据库是一个开源的 积层的卷积核尺寸为 4×4,卷积核数目为 256,步进

英文语音库,为了验证所提算法的有效性,进一步在 为1 × 1,聚合层步长为2 × 2;第三层和第四层为全

中文语音库上进行对比实验。实验在清华大学中文 连接层,每个层由 1024个单元组成;softmax输出层

语音数据集 THCHS30 上进行,该语音库是总时长 由3386个单元组成。

超过 30 h 的汉语普通话数据集,采样频率 16 kHz,

表 2 给出了 THCHS30 测试集上不同模型之间

采样大小 16 bits。其中训练数据集时长约为 25 h,

的对比实验结果:WER 的变化趋势与 TIMIT 数据

共 10000 句;测试数据共 2495 句,全集长度约 6 h。

库的实验结果类似。总体来说,使用本文提出的

选用3-gram的word级统计语言模型。

优化 CNN 算法的语音识别率比一般模型提高了

本实验采用四隐层的 CNN 结构,特征是 40 维

的FBANK,并且相邻的帧由11帧窗口(每侧5个窗 1.49%。从表 1 和表 2 的性能对比实验结果中可看

口) 连接。对每帧声学特征做倒谱均值和归一化以 出,本文所提出的改进 CNN 算法无论是基于英文

获得CNN的输入。其中,CNN的第一个卷积层的卷 语音库还是中文语音库,识别性能均比传统的CNN

积核尺寸为 9 × 9,卷积核数目为 128,步进为 1 × 1, 模型要好。

表 2 THCHS30 测试集上不同模型之间的性能对比

Table 2 Performance comparison between different models on THCHS30 corpus

模型 激活函数类型 代价函数 WER(%)

一般模型 sigmoid 平方误差 23.68

Fisher 模型 sigmoid 平方误差 + Fisher 22.76

Fisher 模型 + L2 正则化 sigmoid 平方误差 + Fisher + L2 22.43

Fisher 模型 + L2 正则化 + log 激活函数 log 激活函数 平方误差 + Fisher +L2 22.19

题,并使得各类音素状态间的距离大,音素状态内的

5 结论 语音数据帧距离小,相比于标准 CNN 网络,改进的

CNN算法的泛化能力更强,语音识别率更高。

本文提出的改进CNN算法将 Fisher准则和 L2

正则化作为惩罚项引入CNN的代价函数中,并基于

参 考 文 献

生物神经元的激活模型提出一种新型的 log 激活函

数,有效地改善了CNN的语音识别性能。在TIMIT [1] 俞栋, 邓力, 俞凯, 等. 解析深度学习语音识别实践 [M]. 北京:

电子工业出版社, 2016.

以及 THCHS30 语音库上的实验结果表明,所提算

[2] 侯一民, 周慧琼, 王政一. 深度学习在语音识别中的研究进展

法较好地缓解了语音识别时容易出现的过拟合问 综述 [J]. 计算机应用研究, 2017, 34(8): 2241–2246.