Page 96 - 应用声学2019年第2期

P. 96

242 2019 年 3 月

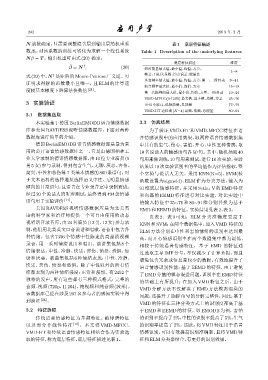

N 就被确定,只需要调整隐含层到输出层的权重系 表 1 底层特征描述

数β i ,对该系数的训练可转化为求解一个线性系统 Table 1 Description of the underlying features

Nβ = T 。输出权重可由式(20) 确定,

底层特征描述 维度

ˆ

β = N , (20) 短时能量最大值、最小值、均值、方差、

†

1∼8

式(20) 中,N 是矩阵的 Moore-Penrose广义逆。可 帧差、自相关系数、均方误差、能量比

†

基音频率最大值、最小值、均值、方差、第一、二阶抖动 9∼14

证明求得解的范数最小且唯一,且 ELM 的计算速

浊音频率最大值、最小值、均值、方差 15∼18

度较基本梯度下降算法快数倍 [21] 。 第一共振峰的最大值、最小值、均值、方差、一阶抖动 19∼24

VMD-MFCC(0-12 阶) 最大值、最小值、均值、方差 25∼76

3 实验验证 DB3 小波高、低频能量、总能量 77∼79

VMD-HT 边际谱 (K=4) 高频、低频、总能量 80∼91

3.1 数据集选取

本实验基于德国 BerlinEMODB语音情感数据 3.3 仿真结果

库和美国 RAVDESS 视听情感数据库,下面对两种 为了验证 VMD-HT 和 VMD-MFCC 特征在语

数据库进行简单的介绍。 音情感识别中的应用效果,取两种语音情感数据集

德国 BerlinEMODB 语音情感数据库是最为常 中共有的生气、伤心、害怕、开心、中性五种情感,取

用的公开语音情感数据库之一,它是由德国柏林工 10名说话人的情感语句各 50句。其中,随机抽取 40

业大学录制的德语情感数据库,由10位专业演员(5 句用来做训练,10句用来测试,进行10次实验,实验

男5女)参与录制,得到包含生气、无聊、厌恶、害怕、 结果以 10次实验识别率的平均值作为评估指标,整

高兴、中性和悲伤等7类基本情感的800条语句。对 个实验与说话人无关。采用 KNN(K=5)、SVM(核

于文本语料的选择遵从选择语义中性、无明显情感 函数设置为 sigmoid)、ELM 作为分类方法,输入为

倾向的日常语句,且语音在专业录音室中录制而成。 91 维底层情感特征,并采用 Sethu V 的 EMD 特征

经过 20 个说话人的听辨测试,最终得到 494 条情感 和向磊的 EEMD 特征进行对比实验,对比实验中

语句用于实验评价 [11] 。 的输入特征中 25∼76 和 80∼91 维分别替换为基于

美国 RAVDESS 视听情感数据库是为北美英 EMD和EEMD的特征。实验结果见表2、表3。

语的科学家和治疗师提供一个可自由使用的动态 由表 2、表 3 可知,ELM 分类准确度要高于

视听语音录音库,由 24名演员 (12 男,12女) 参与录 KNN 和 SVM;在两个数据集中,加入 VMD 特征的

制,他们用北美英文口音说话和唱歌,语音中包含各 ELM 方法分别在中性和害怕情绪的识别率达到最

种情绪。包含 7356 个情感中性陈述的高品质视频 高,而开心情感识别率在两个数据集中都为最低。

录音,用一系列情绪说出和唱出。演讲集包括 8 个 相较于传统语音情感特征,基于 EMD 的特征通

情绪表达:中性、冷静、快乐、悲伤、愤怒、恐惧、惊

过选取主导 IMF 分量,不仅减少了计算负担,而且

讶和厌恶。歌曲集包括 6 种情绪表达:中性、冷静、

避免包含冗余或信息量较少的数据,有效地提升了

快乐、悲伤、愤怒和恐惧。除了中性以外的所有情

语音情感识别性能;基于 EEMD 的特征,由于避免

绪都表现为两种情绪强度:正常和强烈。有2452 个

了EMD分量的模态混叠问题,识别率在 EMD 特征

独特的发声,所有这些都有三种模式格式:完整的

的基础上有所提升;在加入 VMD 特征之后,由于

音频 -视频 (720p,H.264)、纯视频和纯音频 (波形)。

VMD 分解方法不仅解决了 EMD 方法模态混叠的

该数据库已经在涉及 297名参与者的感知实验中得

问题,还提升了 IMF 信号的分解完整性,因此,基于

到验证 [24] 。

VMD 的特征在三种分类方式上的识别度都高于基

3.2 特征选取 于 EMD 和 EEMD 的特征。以 EMODB 为例,害怕

传统语音情感特征为基频特征、韵律谱特征 的识别率提高了2%,中性的识别率提高了5%,生气

以及部分非线性特征 [10] ,本文将 VMD-MFCC、 的识别率提高了 2%。因此,将 VMD 特征用于语音

VMD-HT 和传统语音情感特征相结合作为实验选 情感识别,可以有效提高识别准确率,且将 VMD 特

取的特征,称为底层特征,底层特征描述见表1。 征和ELM分类器结合,有更好的识别效果。