Page 169 - 《应用声学》2022年第5期

P. 169

第 41 卷 第 5 期 张志浩等: 基于 STA-CRNN 模型的语声情感识别 845

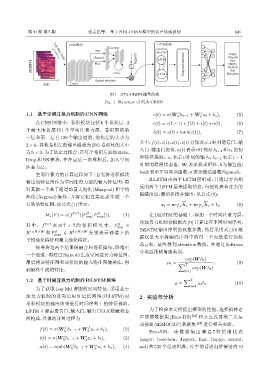

CNNവڱ LSTMവڱ

Connect

Avg

BiLSTM Angry

Channel Sigmoid LSTM Disgust

Fear

Log-Mel, Delta

ᫎऀѵ Max Temporal attention … … Neutral

Happy

Sad

Conv LSTM Boredom

Spatial attention

ྲढ़ Conv

图 1 STA-CRNN 模型结构

Fig. 1 Structure of STA-CRNN

1.1 基于空间注意力机制的CNN网络 o(t) = σ(W h t−1 + W x t + b o ), (5)

o

o

h x

在 CNN 网络中,卷积模块包括 6 个卷积层、2 c(t) = c(t − 1) ∗ f(t) + i(t) ∗ α(t), (6)

个最大池化层和 1 个空间注意力层。卷积层的第

h(t) = o(t) ∗ tanh(c(t)), (7)

一层和第二层有 128 个输出通道,池化层的大小为

其中,f(t)、i(t)、o(t)、c(t) 分别表示 t 时刻遗忘门、输

2 × 4。其他卷积层的输出通道为256,卷积核的大小

入门、输出门的值,α(t)表示t时刻对h t−1 和x t 的初

为5 × 3,为了防止过拟合,在每个卷积后添加Relu、

Drop 和 BN 模块,并在最后一次卷积后,加入空间 步特征提取。x t 表示 t 时刻的输入,h t−1 表示 t − 1

时刻的隐层状态值。W 表示权重矩阵,b 为偏置值;

注意力层。

tanh表示正切双曲函数,σ 表示激活函数Sigmoid。

空间注意力的计算过程如下:首先将卷积模块

BiLSTM 由两个 LSTM 层组成,并通过方向相

输出的特征图作为空间注意力层的输入特征图,再

反的两个 LSTM 层来提取信息,包括将来和过去的

对其做一个基于通道的最大池化(Maxpool)和平均

隐藏信息,最后拼接并输出,见公式(8):

池化 (Avgpool) 操作,并将它们连接起来生成一个

− → ←−

有效的特征图,如公式(1)所示: z t = w−→ h t + w−→ h t + b x . (8)

z x z x

S

S

M s (F) = σ(f 7×7 ([F avg ; F max ])), (1) 在BiLSTM的基础上,添加一个时间注意力层,

该注意力机制会根据式 (9)计算出在不同时间序列,

S

其 中, f 7×7 表 示 7 × 7 的 卷 积 核 尺 寸, F avg ∈ BiLSTM 输出序列的权重参数,然后采用式 (10) 根

S

R 1×H×W 和 F max ∈ R 1×H×W 分别表示通道上的

平均池化特征和最大池化特征。 据权重大小将编码序列中的每一个向量进行加权

求 µ 和,最终得到 attention 数值,并通过 Softmax

接着将这两个结果做融合和卷积操作,降维至

分类器预测情感类别。

一个通道。再经过Sigmoid生成空间注意力特征图。

exp(W h t )

最后将该特征图和该模块的输入特征图做乘法,得 µ t = ∑ T , (9)

到最终生成的特征。 t=1 exp(W h t )

1.2 基于时间注意力机制的BiLSTM网络 ∑ T

µ = µ t h t . (10)

t=1

为了获取 Log-Mel 谱图的时间特征,采用基于

注意力机制的双向长短时记忆网络 (BiLSTM) 对 2 实验与分析

卷积模块的输出结果进行时间序列上的特征提取。

LSTM主要由遗忘门、输入门、输出门以及隐藏状态 为了检验本文所提出模型的性能,选择柏林语

所构成,具体的计算过程为 声情感数据集 (Emo-DB) [24] 和交互式情绪二元运

动捕捉(IEMOCAP)数据集 [25] 进行相关实验。

f f

f(t) = σ(W h t−1 + W x t + b f ), (2)

h x Emo-DB: 该 数 据 集 由 来 自 7 种 情 绪 状 态

i

i

i(t) = σ(W h t−1 + W x t + b i ), (3) (anger、boredom、disgust、fear、happy、neural、

h

x

α

α

α(t) = tanh(W h t−1 + W x t + b α ), (4) sad) 共 535个话语组成。库中的话语由讲德语的 10

h

x