Page 170 - 《应用声学》2022年第5期

P. 170

846 2022 年 9 月

名专业演员 (5 名男性,5 名女性) 记录。Emo-DB 语 小化交叉熵目标函数进行优化,而最大迭代次数设

料库的平均重新编码时间约为 2 ∼ 3 s,采样率为 置为150。

16 kHz。Emo-DB 作为一种标准数据集,已被广泛 2.3 实验结果分析

用于情绪研究。

2.3.1 空间注意力机制在 CNN 层间位置的实验

IEMOCAP:该数据集由 10 名专业演员在 5 个 结果分析

不同的会话中记录,每个会话有 2 名演员 (1名男性,

为了研究 CNN 网络中空间注意力层和卷积层

1名女性)。演员以脚本和即兴版本记录不同情绪的

不同层间位置关系对于识别率的影响,依次把空间

对话,由3 位专家进行注释,并由至少 2 位专家同意 注意力层放入第一层卷积至最后一层卷积之后,记

选择。最终形成包括视频、语声和文本以及 9 种情

为 CNN(AC1)-CNN(AC7),所有的实验均在 Emo-

感 (anger、happy、excitement、sadness、frustration、 DB 库和 IEMOCAP 上进行了 150 次迭代,实验结

fear、surprise、other、neural) 的离散标签,其中语声 果如表1所示。

平均话语时长为3.5 s。由于该数据库存在样本不均

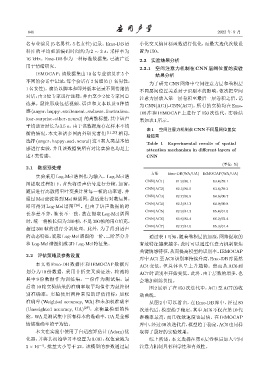

表 1 空间注意力机制在 CNN 不同层间位置实

衡的情况,本文和诸多国内外研究者们 [11,20] 相同,

验结果

选择 (anger、happy、sad、neural) 这 4 类人类基本情

Table 1 Experimental results of spatial

感进行实验,并且该数据集所有对比实验也均是上 attention mechanism in different layers of

述4类情感。 CNN

(单位: %)

2.1 数据预处理

方法 Emo-DB(WA/UA) IEMOCAP(WA/UA)

实验采用 Log-Mel 谱图作为输入。Log-Mel 谱

CNN(AC1) 81.9/80.1 63.4/59.1

图提取过程如下:首先将语声信号进行分帧、加窗,

CNN(AC2) 82.3/80.5 63.6/59.3

随后进行离散傅里叶变换计算每一帧的功率谱,并

CNN(AC3) 82.7/80.9 64.6/60.7

通过 Mel 滤波得到 Mel 频谱图,最后进行对数运算,

CNN(AC4) 82.5/81.3 64.9/60.8

即可得到 Log-Mel 谱图 [26] 。但由于语声数据的时

CNN(AC5) 82.9/81.3 65.4/61.5

长参差不齐,帧长不一致,故在提取 Log-Mel 谱图

CNN(AC6) 83.6/82.4 66.2/62.4

时,统一将帧长归为 300 帧,不足 300 帧的用 0 填充,

CNN(AC7) 82.7/81.0 65.3/61.4

超过 300 帧的进行分割处理。此外,为了得到语声

的动态特征,提取Log-Mel谱图的一阶、二阶差分并 通过表 1可知,随着卷积层的加深,网络提取的

和Log-Mel谱图组成3D Log-Mel特征集。 有效特征越来越多,此时可以通过注意力机制聚焦

关键情感特征,从而提高模型的识别率。IEMOCAP

2.2 评估策略及参数设置

库中AC1至AC6识别率持续升高,Emo-DB库虽然

本文将 Emo-DB 数据库和 IEMOCAP 数据库 AC4 变低,但总体也呈上升趋势。然而从 AC6 到

划分为 10 份数据,采用十折交叉验证法,轮流将 AC7时识别率开始变低。此外,由于层数的增多,也

其中 9 份数据作为训练集,一份作为测试集,最 会增加训练负担。

后将 10 轮实验结果的准确率取平均值作为最终识 图 2 展示了在 150 次迭代中,AC1 至 AC7 的收

别准确率。实验使用两种常见的评估指标:加权 敛曲线。

准确率 (Weighted accuracy, WA) 和未加权准确率 从图 2 中可以看出,在 Emo-DB 库中,经过 80

(Unweighted accuracy, UA) [27] ,来衡量模型的性 次迭代后,模型趋于稳定,其中 AC6 不仅在第 10 代

能。WA是测试集中所有样本的准确率,UA是全部 准确率最高,而且收敛速度也最快。在 IEMOCAP

情绪准确率的平均值。 库中,经过60次迭代后,模型趋于稳定,AC6也同样

本文在实验中使用了自适应矩估计 (Adam)优 取得了最好的实验效果。

化器,并将其初始学习率设置为 0.001,权值衰减为 综上所述,本文选择在第 6 层卷积后加入空间

5 × 10 −4 ,批量大小等于 32。该模型的参数通过最 注意力机制具有科学性和有效性。