Page 85 - 《应用声学》2025年第3期

P. 85

第 44 卷 第 3 期 林怡等: 使用自注意力机制及数据增强策略的乐曲风格识别方法 619

enbedding 部分。该方法将 Mel 频谱图按时间序列 号随时间变化的动态特性。通过这种划分,模型

划分为多个patch,每个Patch包含了一段时间内的 不仅能够学习声频中的局部频率特征,还能通过

全部频率信息,这种做法有效地保留了声频数据的 transformer 架构学习这些特征之间随时间变化的

时序信息和频率细节。模型可以在多个时序 patch 复杂关系,从而更准确地识别和理解声频中的风格

之间进行特征融合,进一步增强对声频信号中跨时 和内容。

间特征的捕捉能力。这对于识别包含复杂节奏和变

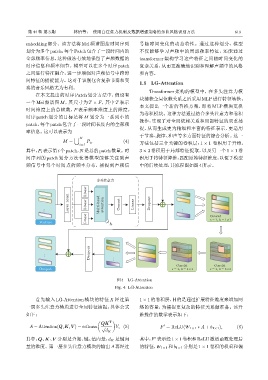

1.5 LG-Attention

奏的音乐风格尤为有利。

Transformer 架构的模型中,在多头注意力模

在本文提出的时序 Patch 划分方法中,假设有

块捕获全局依赖关系之后采用 MLP进行特征转换。

一个 Mel 频谱图 M,其尺寸为 T × F,其中 T 表示

本文提出一个新的替换方案,即将 MLP 模块更换

时间维度上的总帧数,F 表示频率维度上的维度。

为卷积模块。这种方法通过结合多头注意力和卷积

时序 patch 划分的目标是将 M 划分为一系列小的

操作,实现了对全局依赖关系和局部特征的双重捕

patch,每个 patch 包含了一段时间长度内的全部频

捉,从而生成更为精细和丰富的特征表示,更适用

率信息。这可以表示为

于节奏、旋律、和声等多方面特征的综合分析。这一

∪ N

M = P i , (4) 方法包括三个关键的卷积层:1 × 1 卷积用于升维,

i=1

其中,P i 表示第i个patch,N 是总的patch数量。时 3 × 3 卷积用于局部特征提取,以及另一个 1 × 1 卷

间序列的 patch 划分方法使得模型能够关注到声 积用于将特征降维,匹配原始特征维度,以便于模型

频信号中每个时间点的频率分布,捕捉到声频信 中的后续处理,其流程图如图4所示。

ܳ݀ฌਓҧ

Linear

Layer norm Linear Multi-head attention Concat Linear Dropout ...

...

Linear Conv2d v2d

Con

s=1, k=1f1

Feature h

Dropout

...

...

Conv2d Conv2d

Output s=1, k=1f1 s=1, k=3f3

图 4 LG-Attention

Fig. 4 LG-Attention

首先输入 LG-Attention 模块的特征 X 经过第 1 × 1的卷积层,目的是通过扩展特征维度来增加网

一层多头注意力模块进行全局特征捕捉,具体公式 络的容量,为捕捉更复杂的特征关系做准备。该升

如下: 维操作的数学表示如下:

( T )

QK

′

A = Attention(Q, K, V ) = softmax √ V, (5) F = ReLU(W 1×1 ∗ A + b 1×1 ), (6)

d K

其中,Q、K、V 分别是查询、键、值向量,d K 是键向 其中,F 表示经1 × 1卷积和ReLU激活函数处理后

′

量的维度。第一层多头注意力模块的输出A再经过 的特征,W 1×1 和b 1×1 分别是1 × 1 卷积的权重和偏