Page 146 - 《应用声学》2021年第3期

P. 146

464 2021 年 5 月

FPR取值范围为[0, 1],值越接近0,分类性能越好。 每次分类实验共进行 12000 次训练,每次从训

练集中按照顺序抽取 8 个样本输入网络进行训练,

3.1.3 假阴性率

即 batch_size 设置为 8,训练集抽取完成一个批次

假阴性率(False negative rate, FNR)表示真实

(epoch) 后对训练集进行一次打乱。若将训练集样

值为 1 但被预测为 0 的样本数量在所有真实值为 1

本数定义为data_size,则每个批次可以表示为

的样本中占的比例,其公式表达为

data_size

epoch = . (15)

N FN

FNR = . (13) batch_size

N TP + N FN

每训练 100 次记录一次损失函数、训练准确率

FNR取值范围为[0, 1],值越接近0,分类性能越好。

和测试准确率。训练和测试结束后分别计算验证集

3.1.4 调和平均数 的准确率、假阳性率和假阴性率和调和平均数。

当存在极偏数据时,单独使用 FPR 和 FNR 很

3.3 实验结果与分析

难对整体的分类性能进行客观评价,需要使用一个

3.3.1 相同输入和不同网络的实验结果分析

两者兼顾的指标。调和平均数 (Harmonic average,

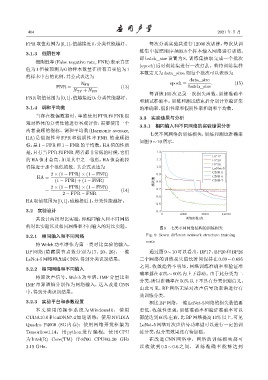

七类不同网络的训练损失,训练和测试准确率

HA) 是假阳性率 FPR 和假阴性率 FNR 的兼顾指

如图9 ∼ 10所示。

标,是1 − FPR和1 − FNR的平均数。HA值的性质

是,只有当FPR和FNR 两者都非常低的时候,它们 1.2

BP17

的 HA 值才会高,如果其中之一很低,HA 值会被拉 1.1 BP20

BP26

得接近于那个很低的数。其公式表达为 1.0 LeNet¹5

CNN¹5

2 × (1 − FPR) × (1 − FNR) 0.9

HA = CNN¹6

(1 − FPR) + (1 − FNR) ૯ܿϙ 0.8 CNN¹7

2 × (1 − FPR) × (1 − FNR)

= . (14) 0.7

2 − FPR − FNR

0.6

HA取值范围为[0, 1],值越接近1,分类性能越好。

0.5

3.2 实验设计 0.4

0 4000 8000 12000

共设计两组对比实验,即相同输入和不同网络 ᝫጷ/

的对比实验以及相同网络和不同输入的对比实验。 图 9 七类不同网络结构的训练损失

3.2.1 相同输入和不同网络 Fig. 9 Seven different network structure training

costs

将 Welch 功率谱作为第一类对比实验的输入,

BP 网络 (隐藏层节点数分别为 17、20、26)、一维 通过图 9 ∼ 10 可以看出,BP17、BP20 和 BP26

LeNet-5网络和改进CNN,得到分类识别结果。 三个网络的训练损失值长时间保持在 0.69 ∼ 0.695

之间,收敛趋势不明显,网络训练准确率和验证准

3.2.2 相同网络和不同输入

确率都在40% ∼ 60%内上下浮动。由于此分类为二

将原次声信号、Welch 功率谱、IMF 分量比和

分类,所以准确率在50%以下不具有分类识别意义。

IMF 奇异谱熵分别作为网络输入,送入改进 CNN

由此可见,BP 网络无法对次声信号功率谱进行有

中,得到分类识别结果。

效训练分类。

3.2.3 实验平台和参数设置 相比BP网络,一维LeNet-5网络的损失数值要

本文使用的操作系统为 Windows10, 使用 更低,收敛性更强,训练准确率和验证准确率可以

CUDA10.0 和 cuDNN7.4 加速训练;使用 NVIDIA 都能达到60%左右,比BP网络提高10%以上,可见

Quadro P4000 (8G 内存);使用网络开发框架为 LeNet-5 网络对次声信号功率谱可以进行一定的训

Tensorflow1.14;用 python 进行编程;使用 CPU 练分类,但分类效果还有待加强。

为 Intel(R) Core(TM) i7-8700 CPU@3.20 GHz 在改进 CNN 网络中,网络的训练损失都可

3.19 GHz。 以收敛到 0.5 ∼ 0.6 之间。 训练准确率能够达到